Es extraño pensar que antes de que hace un siglo atrás comenzarán a circular las primeras imágenes de video, mediante cortometrajes mudos en blanco y negro, no pasaría mucho tiempo para que los primeros rostros no humanos, generados por medios digitales, nos bombardearan en las más variadas formas. Desde extraterrestres exóticos del universo de Star Treck o Star Wars, hasta la marejada de videojuegos con personajes que podíamos customizar para parecerse a nosotros o generar algo nuevo, una especia de ideal o experimento de facciones con el que nos pudiéramos identificar. Y esta generación de rostros digitales no ha hecho más que aumentar con la optimización de los algoritmos y redes neuronales de inteligencia artificial.

La generación de la tecnología de deepfake es un mercado pujante y que puede prestarse para la corrupción. Ya que una vez que tus imágenes circulan por las corrientes del internet es difícil que no puedan ser manipuladas por terceros y usadas para fines tan variados como hacer propagandas o montar videos pornográficos. Todo sin ningún tipo de consentimiento. De allí que sea tan importante manejar tus datos y conservar el control sobre la privacidad de tus perfiles virtuales.

En este artículo de Neura Pod en castellano te contaremos sobre una investigación que arrojó resultados sorprendentes sobre nuestra apreciación de qué rostros son sintéticos y cuáles reales. La brecha parece estar difuminándose.

Para poner algo de contexto tenemos que recordar que, ya en 2018, Nvidia sorprendió al mundo con una IA capaz de producir fotos ultrarrealistas de personas que no existen. Sus investigadores se basaron en un tipo de algoritmo conocido como red generativa adversarial (GAN), que enfrenta a dos redes neuronales entre sí, una tratando de detectar las falsificaciones y la otra intentando generar otras más convincentes. Con el tiempo suficiente, la GAN puede generar falsificaciones notablemente buenas.

No hay que ser adivino para descubrir que de allí en adelante las capacidades han mejorado considerablemente, con algunas implicaciones preocupantes: permitir a los estafadores engañar a la gente y socavar la confianza en los medios de comunicación en línea, entre otras alteraciones. Aunque es posible utilizar la propia IA para detectar las falsificaciones profundas, el fracaso de las empresas tecnológicas a la hora de moderar eficazmente material mucho menos complicado sugiere que esto no será una bala de plata.

Esto significa que la pregunta más pertinente es si los seres humanos pueden detectar la diferencia y, lo que es más importante, cómo se relacionan con los deepfakes. Los resultados de un nuevo estudio publicado en PNAS no son prometedores: los investigadores descubrieron que la capacidad de las personas para detectar las falsificaciones no era mejor que una suposición al azar, y de hecho calificaron las caras inventadas como más fiables que las reales.

"Nuestra evaluación del fotorrealismo de los rostros sintetizados por la IA indica que los motores de síntesis han superado el valle misterioso y son capaces de crear rostros indistinguibles -y más fiables- que los reales", escriben los autores.

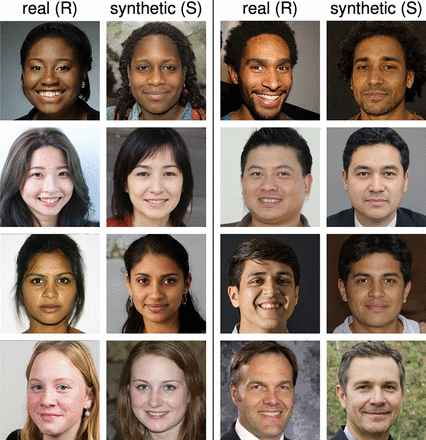

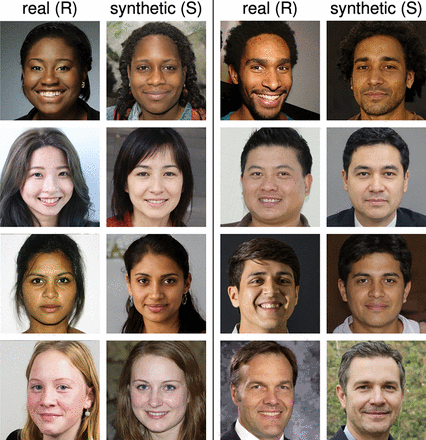

Para comprobar las reacciones a los rostros falsos, los investigadores utilizaron una versión actualizada de la GAN de Nvidia para generar 400 de ellos, con una división equitativa de sexos y 100 rostros de cada uno de los cuatro grupos étnicos: Negros, caucásicos, asiáticos y sudasiáticos. Compararon cada una de ellas con rostros reales extraídos de la base de datos que se utilizó originalmente para entrenar la GAN, que habían sido juzgados como similares por una red neuronal diferente.

A continuación, reclutaron a 315 participantes de la plataforma de crowdsourcing Amazon Mechanical Turk. A cada persona se le pidió que juzgara 128 caras del conjunto de datos combinados y decidiera si eran falsas o no. Consiguieron una tasa de precisión de tan solo el 48%, en realidad peor que el 50% que se debería obtener de una suposición aleatoria.

Los deepfakes suelen tener defectos y fallos característicos que pueden ayudar a distinguirlos. Así que los investigadores llevaron a cabo un segundo experimento con otros 219 participantes a los que dieron un entrenamiento básico sobre lo que debían tener en cuenta antes de hacerles juzgar el mismo número de caras. Su rendimiento sólo mejoró ligeramente, hasta el 59%.

En un último experimento, el equipo decidió ver si las reacciones viscerales más inmediatas a las caras podían dar mejores pistas a las personas. Decidieron comprobar si la fiabilidad -algo que solemos decidir en una fracción de segundo basándonos en rasgos difíciles de precisar- podría ayudar a la gente a hacer mejores llamadas. Pero cuando pidieron a otros 223 participantes que calificaran la fiabilidad de 128 rostros, descubrieron que la gente calificaba los falsos como un 8 por ciento más fiables, una diferencia pequeña pero estadísticamente significativa.

Teniendo en cuenta los usos nefastos que pueden darse a las falsificaciones, el resultado es preocupante. Los investigadores sugieren que parte de la razón por la que las caras falsas se valoran más es porque tienden a parecerse más a las caras normales, en las que, según investigaciones anteriores, la gente tiende a confiar más. Esto se comprobó al observar las cuatro caras menos fiables, que eran todas reales, y las tres más fiables, que eran todas falsas.

Esta tendencia parece solo el comienzo, pues ya está claro que tendemos a confiar o asignar mayor belleza a rostros que cumplen con ciertos estándares de simetría, lo que es, a esta altura, replicable con bastante eficacia por estas tecnologías, como demuestra el estudio. Los investigadores afirman que sus hallazgos sugieren que quienes desarrollan la tecnología subyacente a las falsificaciones profundas deben reflexionar sobre lo que están haciendo. Un primer paso importante es preguntarse si los beneficios de la tecnología son mayores que sus riesgos. La industria también debería considerar la posibilidad de incorporar salvaguardas, que podrían incluir cosas como hacer que los generadores de deepfakes añadan marcas de agua a sus resultados.

"Dado que la democratización del acceso a esta poderosa tecnología es lo que plantea la amenaza más importante, también animamos a reconsiderar el enfoque, a menudo laissez-faire, de la liberación pública y sin restricciones del código para que cualquiera lo incorpore a cualquier aplicación", escribieron los autores.

La verdad es que esta tecnología ya está en las manos de industrias que ponen sus propios intereses económicos por sobre otras consideraciones éticas. Sobre todo, si hablamos de la publicidad y el big tech, como ha demostrado el problema de la manipulación de datos y el registro de datos no autorizados por los usuarios en gigantes tecnológicos como Google y Facebook. Además, es difícil convencer a publicistas que no ocupen una tecnología que parece producir rostros más confiables que los de actores que requieren una paga y contrato de por medio. Parece ser un atajo rentable. Y cuando eso pasa la ética pasa a un segundo plano. Por lo mismo no sería sensato sentarnos a esperar que pasa. Más temprano que tarde podríamos estar interactuando con bots con rostros digitales o inteligencias artificiales, como GPT-3, de las cuales ya no sabemos si son seres humanos o no. Definitivamente es una tecnología que llegó para quedarse y puede tener enormes consecuencias, por lo que hay que seguirle la pista.